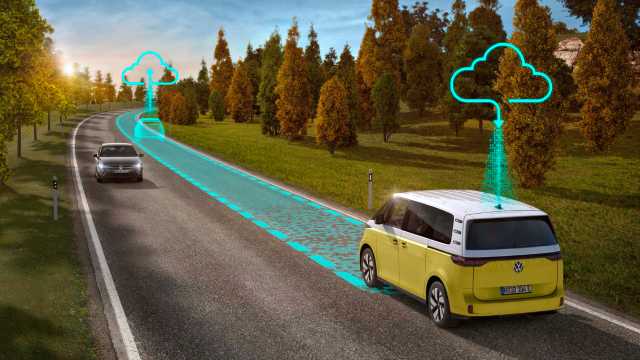

Addestrare l'IA per rendere la guida autonoma affidabile in ogni situazione

I veicoli a guida completamente autonoma saranno in grado di gestire anche le situazioni più complesse e non si faranno sorprendere dagli imprevisti, grazie a un alto grado di quella che viene definita robustezza.

Guidare un'auto non è sempre semplice: ci sono condizioni in cui può essere particolarmente impegnativo, come in caso di nebbia. Oltre a ridurre la velocità e accendere le luci antinebbia, bisogna stare attenti alla segnaletica orizzontale e fare i conti con la visibilità limitata. Non è una situazione ottimale e nemmeno piacevole, ma si riesce comunque a gestirla, entro certi limiti.

In altre parole, ci sono situazioni in cui guidare è più complicato ma è comunque possibile - e ovviamente anche i software della guida autonoma devono essere in grado di affrontarle in modo ottimale. Questa stabilità funzionale che un sistema deve avere anche quando i fattori esterni rendono il suo compito più difficile si chiama robustezza.

Gestire gli imprevisti

Quando si parla di guida autonoma la robustezza riguarda imprevisti come la lente sporca di una fotocamera o un sensore in avaria; in questi casi un veicolo a guida completamente autonoma dovrà comunque essere in grado di muoversi in piena sicurezza. Anche dettagli come i colori dei veicoli o i vestiti dei pedoni non devono creare problemi: il sistema deve identificarli correttamente.

Questi elementi non creano difficoltà ai conducenti in carne e ossa, ma possono diventare una sfida per il software del veicolo, che prende decisioni basandosi sull'intelligenza artificiale. Proprio per questo i sistemi basati sulla IA devono essere addestrati e avere una robustezza tale da non essere influenzati dalle ‘perturbazioni’ esterne, che potrebbero indurli a prendere decisioni errate e potenzialmente pericolose.

La classificazione

Allo stato attuale, su questo aspetto anche le IA più avanzate vanno ottimizzate: bastano piccole modifiche ai dati elaborati da un modulo IA, per esempio una differenza di due pixel in un'immagine, per confondere il sistema e portarlo a conclusioni fuorvianti. Definire algoritmi di apprendimento automatico (machine learning) affidabili e sicuri è un passo fondamentale nella ricerca scientifica e non solo per i veicoli a guida autonoma, ma in tutti i settori.

Ma come fa un algoritmo a giungere a conclusioni fuorvianti? Il motivo è la “classificazione”, ovvero una parte del metodo di apprendimento dell'intelligenza artificiale. Se c'è un gruppo di immagini simili tra loro, per esempio di cani e gatti, che sono mammiferi e quadrupedi, con una testa e una coda ma comunque diversi, la differenziazione tra i due animali è il limite di classificazione. Se viene modificata leggermente l'immagine di un gatto per farlo assomigliare a un cane, la IA cambierà idea e lo classificherà come cane.

Allenare la IA

Per addestrare la robustezza di un sistema AI e metterne alla prova la capacità di classificazione, si può modificare un'immagine: la si può ruotare e cambiarne colore, allenando l'intelligenza artificiale a prendere costantemente le decisioni giuste. Ma i fattori da considerare quando si garantisce la robustezza per l'intelligenza artificiale dei veicoli a guida autonoma sono molti altri e il tempo è uno di questi. Se un sistema di intelligenza artificiale non riconosce un pedone entro 5 millisecondi potrebbe non essere un problema, ma se non lo riconosce entro 10 secondi è sicuramente un problema.

Il tempo, però, non è l'unico fattore: anche gli eventi hanno il loro effetto sulla corretta etichettatura da parte dell'intelligenza artificiale. Un sistema potrebbe essere più efficace nell'identificare un pedone che attraversa la strada piuttosto che un ciclista che si trova dietro a un'auto.

La robustezza

Determinare la robustezza di un sistema vuol dire considerarla nel contesto della sicurezza complessiva di una funzione - e la sicurezza non è un concetto astratto, ma sempre una proprietà del sistema. Le reti neurali e le funzioni di percezione non sono mai sicure o non sicure di per sé, perché gli errori che possono contenere non rappresentano un rischio immediato per l'ambiente del veicolo o per gli occupanti.

Così, una parte fondamentale del processo di sicurezza è l'analisi e la valutazione dei limiti delle prestazioni, cioè delle possibili fonti di errori e dei loro effetti. Su questo aspetto la robustezza delle reti neurali è fondamentale e i requisiti che la determinano si basano sia sul contesto - ambiente e situazione di guida - sia sugli obiettivi di sicurezza, che devono minimizzare il rischio residuo.

Affidabilità totale

L'obiettivo finale è massimizzare il numero di condizioni che un software per la guida autonoma è in grado di gestire con un elevato grado di robustezza.

Tenendo presente tutto questo è facile capire perché l'addestramento di un modulo AI per veicoli automatizzati è un processo estremamente lungo e complesso. Tuttavia è un prerequisito necessario per aiutare i veicoli a guida autonoma a diventare robusti; solo in questo modo potranno diventare autisti affidabili in tutte le condizioni.

Fonte: CARIAD

VGI | U.O. Responsabile: VP | Data di creazione: data dell’articolo | Classe 9.1